- Bahay

- >

- Ulap

- >

- Batch Compute

- >

Batch Compute

2025-12-04 17:23Ang Tencent Cloud Batch Computing (Batch) ay isang low-cost distributed computing platform na ibinigay para sa mga negosyo at institusyon ng pananaliksik. Ang pangunahing pokus nito ay sa mga pangangailangan sa pagpoproseso ng batch ng data. Big Data Batch Processing man ito, Batch Processing para sa ML Training, o Batch Video Rendering, maaari itong magbigay ng mahusay at matatag na suporta sa computational sa pamamagitan ng matalinong pag-iiskedyul ng mapagkukunan at ganap na pinamamahalaang mga end-to-end na serbisyo. Bilang pangunahing tool para sa Batch Data Processing, sinusuportahan ng Batch Computing ang dynamic na configuration ng mga mapagkukunan ng computing, na nagbibigay-daan sa elastic scaling upang mahawakan ang mga gawain sa Big Data Batch Processing na may iba't ibang sukat. Ang tampok na zero upfront cost nito ay makabuluhang nagpapababa sa hadlang sa pagpasok para sa mga negosyo. Para sa Batch Processing para sa ML Training, sinusuportahan nito ang multi-instance concurrency at task dependency modeling, na nagpapagana ng mabilis na pag-setup ng mga distributed training environment at nagpapabilis ng pag-ulit ng modelo. Sa mga sitwasyon ng Batch Video Rendering, ang Batch Computing ay maaaring bumuo ng mga automated rendering pipeline. Gamit ang napakalaking mapagkukunan at mga kakayahan sa pag-iiskedyul ng trabaho, mahusay nitong nakumpleto ang Batch Data Processing para sa visual na paggawa ng trabaho. Malalim na isinasama ang Batch Computing sa mga serbisyo ng cloud tulad ng Object Storage (COS), na nakakamit ng one-stop closed loop mula sa pagkuha ng data, computing execution, hanggang sa imbakan ng resulta. Nagbibigay-daan ito sa mga user na tumuon sa pangunahing pagpoproseso at pagsusuri ng data nang hindi nababahala tungkol sa pamamahala ng mapagkukunan at pag-deploy ng kapaligiran, na ginagawa itong mas gustong solusyon para sa mga sitwasyon tulad ng Big Data Batch Processing, Batch Processing para sa ML Training, at Batch Video Rendering.

Mga Madalas Itanong

T: Bilang isang pangunahing platform para sa Batch Data Processing, paano sinusuportahan ng Batch Computing nang sabay-sabay at mahusay ang dalawang natatanging pangangailangan ng Big Data Batch Processing at Batch Video Rendering?

A: Batch Computing, na may kakayahang umangkop na pag-iiskedyul ng mapagkukunan at ganap na pinamamahalaang mga end-to-end na kakayahan, perpektong umaangkop sa dalawang uri ng Batch Data Processing na mga pangangailangan. Para sa Big Data Batch Processing, sinusuportahan nito ang dynamic at elastic scaling ng computing resources, na sinamahan ng storage mounting functions para ma-enable ang mabilis na pag-access sa napakalaking dataset, na nakakatugon sa mga high-concurrency na hinihingi ng TB/PB-level Big Data Batch Processing. Para sa Batch Video Rendering, ang Batch Computing ay maaaring gumamit ng DAG workflow editing para bumuo ng rendering dependency pipelines, na ipinares sa multi-instance concurrent execution, na mahusay na nagsusulong ng malakihang mga gawain sa pag-render. Samantala, ang ganap na pinamamahalaang katangian ng Batch Computing ay nangangahulugan na ang parehong uri ng Batch Data Processing ay hindi nangangailangan ng manu-manong interbensyon sa paggawa at pagkasira ng mapagkukunan. Kung ito man ay ang mga kumplikadong pagpapatakbo ng data ng Big Data Batch Processing o ang compute-intensive na mga gawain ng Batch Video Rendering, maaari silang kumpletuhin nang may mababang gastos at mataas na kahusayan, na ganap na napagtatanto ang pangunahing halaga ng Batch Computing.

Q: Ano ang mga pangunahing bentahe ng pagpili ng Batch Computing para sa Batch Processing para sa ML Training? Matutugunan din ba nito ang mga kinakailangan sa kahusayan ng Big Data Batch Processing?

A: Ang mga pangunahing bentahe ng pagpili ng Batch Computing para sa Batch Processing para sa ML Training ay makikita sa tatlong punto: Una, sinusuportahan nito ang pagmomodelo ng dependency sa gawain, na nagbibigay-daan sa flexible na orkestrasyon ng mga workflow ng pagsasanay upang umangkop sa maraming yugto ng mga pangangailangan ng Batch Processing para sa ML Training. Pangalawa, ang elastic resource scaling nito ay maaaring dynamic na isaayos ang bilang ng mga pagkakataon batay sa laki ng gawain sa pagsasanay, pag-iwas sa pag-aaksaya ng mapagkukunan. Pangatlo, ang malalim na pagsasama nito sa cloud storage ay nagpapadali sa pag-access sa data ng pagsasanay at mga file ng modelo. Kasabay nito, ang mga bentahe na ito ay maaari ding ganap na matugunan ang mga kinakailangan sa kahusayan ng Big Data Batch Processing — ang multi-instance concurrency na kakayahan ng Batch Computing ay maaaring mapahusay ang bilis ng pagproseso ng Big Data Batch Processing, at ang storage mounting function nito ay nagsisiguro ng mahusay na access sa napakalaking dataset. Dahil dito, ang Batch Computing ay isang all-in-one na platform na may kakayahang suportahan ang parehong Batch Processing para sa ML Training at Big Data Batch Processing, na higit na binibigyang-diin ang versatility ng mga kakayahan nito sa Batch Data Processing.

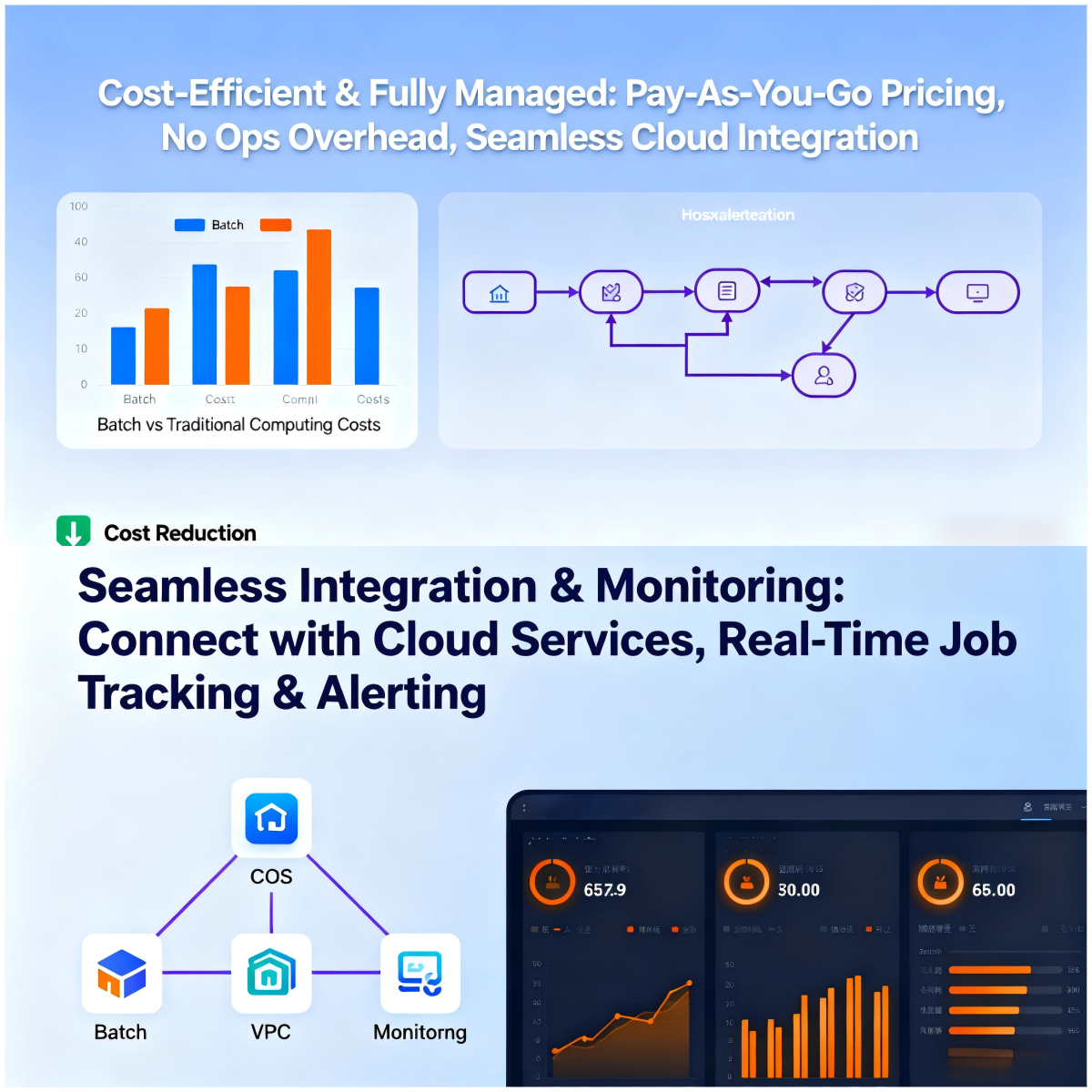

T: Kapag nagsagawa ang mga negosyo ng Batch Video Rendering at Big Data Batch Processing, paano nila makakamit ang cost optimization at pagpapasimple ng proseso sa pamamagitan ng Batch Computing?

A: Tinutulungan ng Batch Computing ang mga negosyo na i-optimize ang mga gastos at pasimplehin ang mga proseso sa pamamagitan ng dalawahang mekanismo. Tungkol sa gastos, sinusuportahan ng Batch Computing ang pay-as-you-go billing, na lumilikha ng mga CVM instance lamang sa panahon ng Batch Data Processing at awtomatikong sinisira ang mga ito pagkatapos ng mga gawain. Binabawasan ng zero upfront cost na ito ang mga pangunahing gastos para sa Big Data Batch Processing at Batch Video Rendering. Kasabay nito, tinitiyak ng dynamic na pagsasaayos ng mapagkukunan na ang mga mapagkukunan ay eksaktong tumutugma sa mga hinihingi sa gawain, pag-iwas sa walang ginagawang pag-aaksaya. Tungkol sa mga proseso, ang Batch Computing ay nagbibigay ng isang sopistikadong function ng kahulugan ng gawain, na nagpapagana ng mabilis na pagsasaayos ng mga kapaligiran sa pag-compute at mga utos ng pagpapatupad nang walang manu-manong pag-deploy. Para sa pipeline na pangangailangan ng Batch Video Rendering at ang mga kumplikadong workflow ng Big Data Batch Processing, ang DAG workflow editing at task dependency modeling function ay nagbibigay-daan sa full-process automation. Kasama ng public command library at mga kakayahan sa pagsasama ng API, pinapasimple nito ang buong Batch Data Processing journey mula sa pagsusumite ng gawain hanggang sa output ng resulta. Kung para sa Batch Processing para sa ML Training o iba pang batch computing scenario, maaari itong maipatupad nang mahusay.